O ChatGPT (Chat Generative Pre‐Trained Transformer), lançado pela OpenAI em 2022, é um modelo avançado de linguagem em inteligência artificial (IA) capaz de interagir em conversas e fornecer respostas originais. Apesar da grande especulação, sua utilização para auxílio na tomada de decisão clínica ainda não é recomendada em vitude da falta de informações sobre seu conhecimento técnico em Medicina e dos potenciais impactos éticos envolvidos.1,2

Como primeiro passo para obter essas informações, o ChatGPT tem sido recentemente testado em provas de título de diferentes especialidades médicas.3–5 No Brasil, poucos estudos foram realizados nesse sentido e, até o momento, nenhum avaliou seu desempenho na prova de Título de Especialista em Dermatologia (TED).

O TED é obtido por exame anual oferecido pela Sociedade Brasileira de Dermatologia (SBD), tendo como primeira fase eliminatória uma prova teórica composta por 80 questões objetivas, com quatro alternativas cada e apenas uma opção correta. São eliminados do concurso os candidatos que acertarem menos de 60% do total (48 questões corretas).6 Realizamos este trabalho com o objetivo de avaliar o desempenho dessa IA nesse exame e ponderar sua utilização na Dermatologia.

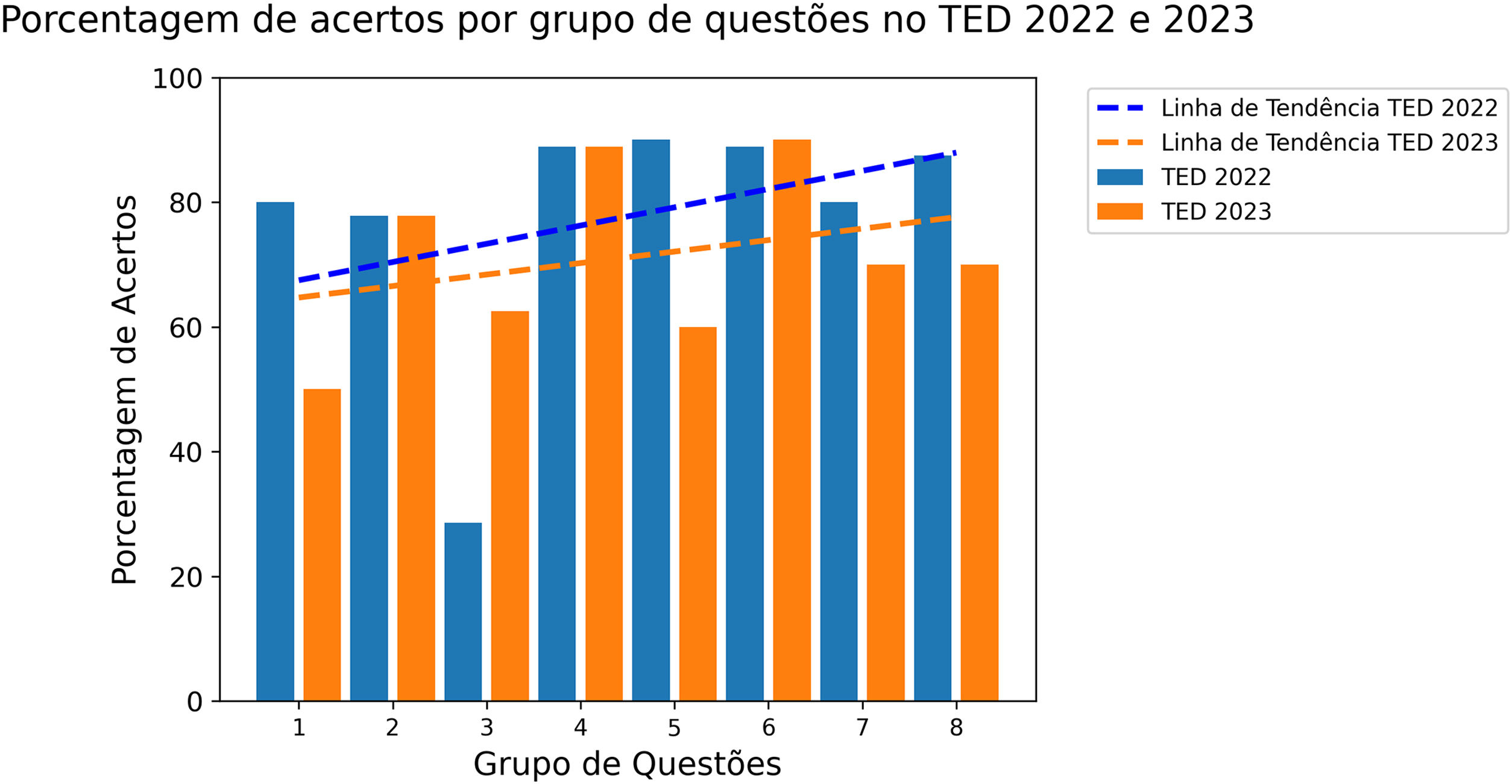

Avaliamos a performance do ChatGPT (versão 4) por meio da resolução das questões do TED 2022 e 2023, disponíveis no site da SBD. Foram desconsideradas as questões com imagens, pela ausência dessa funcionalidade, e as anuladas. As questões foram classificadas em dermatologia clínica, laboratorial, cirúrgica e cosmiatria. O aplicativo foi instruído a responder questões de múltipla escolha. Em seguida, apresentou‐se uma questão por vez para que ele escolhesse a alternativa mais adequada. A acurácia geral foi medida como a razão entre o número de respostas corretas e o total de questões. Também foi avaliada a acurácia por ano de prova e para cada área, comparando a média das provas usando o teste t de Student ou Mann‐Whitney, dependendo da normalidade dos dados, a qual foi verificada por meio do teste de Shapiro‐Wilk. Em seguida, avaliamos a variação do desempenho ao longo da prova agrupando todas as questões em grupos de 10 em 10, seguindo a ordem da prova. Em cada grupo calculou‐se a porcentagem de acerto, desconsiderando questões anuladas e com imagens daquele grupo. Utilizou‐se o teste de Spearman para avaliar a correlação entre a porcentagem de acerto dos grupos e o número da questão inicial do respectivo bloco, assim como uma linha de tendência gráfica utilizando a regressão linear, buscando identificar se houve melhora do desempenho no decorrer da prova.

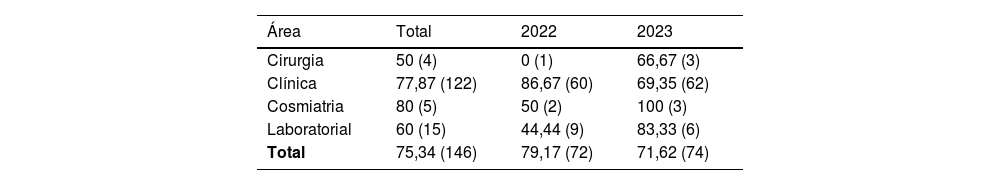

Foram analisadas um total de 146 questões, das quais 74 do TED 2023 e 72 do TED 2022. Foram excluídas nove questões anuladas e cinco por uso de imagem. A acurácia geral foi de 75,34%, e a média de desempenho na prova de 2022 foi superior à de 2023 (fig. 1). No teste estatístico de comparação entre as provas, como não houve normalidade dos dados, foi feito o teste de Mann‐Whitney, valor de p de 0,29. A área com mais acertos foi a de cosmiatria, e a com menos, de cirurgia (tabela 1). As linhas de tendência mostram inclinação positiva, sugerindo melhora do desempenho no decorrer da prova em ambos os anos (fig. 2). A análise de correlação de Spearman revelou correlação positiva e moderada, porém não significante, para o TED 2022 (correlação=0,43, p=0,28) e TED 2023 (correlação=0,32, p=0,43).

Distribuição percentual dos acertos por área e ano, com o total de questões entre parênteses

| Área | Total | 2022 | 2023 |

|---|---|---|---|

| Cirurgia | 50 (4) | 0 (1) | 66,67 (3) |

| Clínica | 77,87 (122) | 86,67 (60) | 69,35 (62) |

| Cosmiatria | 80 (5) | 50 (2) | 100 (3) |

| Laboratorial | 60 (15) | 44,44 (9) | 83,33 (6) |

| Total | 75,34 (146) | 79,17 (72) | 71,62 (74) |

O desempenho do ChatGPT nos exames de obtenção do TED de 2022 e 2023 foi acima do exigido para a obtenção da aprovação na primeira fase do concurso. No entanto, uma avaliação comparativa dos desempenhos anuais não revelou diferença estatisticamente relevante, impedindo uma afirmação conclusiva de superioridade de um ano em relação ao outro. A análise de desempenho no decorrer da prova sugere uma tendência à probabilidade de acerto das questões aumentar conforme mais questões são realizadas, embora mais questões sejam necessárias para alcançar valor estatístico mais significante. As categorias com melhor desempenho foram cosmiatria e clínica, sugerindo predominância dessas áreas no banco de dados de treinamento do ChatGPT.

Os resultados foram consonantes com outros experimentos em avaliações médicas já realizados. Um artigo recém‐publicado demonstrou que o ChatGPT tem desempenho equivalente ao de um estudante de Medicina do terceiro ano ao responder às perguntas dos exames de licenciamento médico dos Estados Unidos (USMLE).3 Na Dermatologia, o aplicativo já foi utilizado para resolver questões da prova de certificação de especialidade no Reino Unido. No estudo, o ChatGPT‐3.5 obteve pontuação geral de 63,1%, e o ChatGPT‐4 obteve 90,5%. A nota de aprovação esperada para o SCE de Dermatologia é de 70%–72%.4

Embora os resultados sejam promissores, ainda não há estudos que embasem o uso do ChatGPT na prática médica.2 Uma grande limitação para sua aplicação na Dermatologia é a não avaliação de imagens, considerando o caráter visual da especialidade. É preciso cautela na incorporação da IA na prática dermatológica, além de ser essencial a realização de novas pesquisas com colaboração de especialistas em dermatologia e em IA para aprimorar a compreensão dos seus potenciais riscos e benefícios. O exame clínico minucioso e uma boa relação médico‐paciente permanecem sendo, até o momento, as melhores ferramentas para a prática clínica segura, confiável e efetiva da especialidade.

Suporte financeiroNenhum.

Contribuição dos autoresThaís Barros Felippe Jabour: Concepção e desenho do estudo; levantamento, análise e interpretação dos dados; revisão crítica da literatura; redação do artigo ou revisão crítica do conteúdo intelectual importante.

José Paulo Ribeiro Júnior: Levantamento, análise e interpretação dos dados; revisão crítica da literatura; redação do artigo ou revisão crítica do conteúdo intelectual importante.

Alexandre Chaves Fernandes: Concepção e desenho do estudo; análise estatística; redação do artigo ou revisão crítica do conteúdo intelectual importante.

Cecília Mirelle Almeida Honorato: Revisão crítica da literatura; redação do artigo ou revisão crítica do conteúdo intelectual importante.

Maria do Carmo Araújo Palmeira Queiroz: Revisão crítica do conteúdo; aprovação final da versão final do manuscrito.

Conflito de interessesNenhum.

Como citar este artigo: Jabour TBF, Ribeiro Junior JP, Fernandes AC, Honorato CMA, Queiroz MCAP. ChatGPT: Performance of artificial intelligence in the dermatology specialty certificate examination. An Bras Dermatol. 2024;99:277–9.

Trabalho realizado no Departamento de Dermatologia, Hospital Universitário Onofre Lopes, Universidade Federal do Rio Grande do Norte, Natal, RN, Brasil.